芯片测试数据分析:驱动产品质量与可靠性的核心引擎

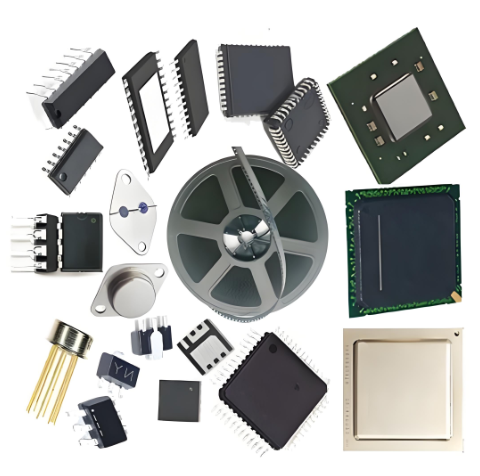

在当今高度数字化的世界中,芯片已成为现代科技的基石,从智能手机到数据中心,从汽车电子到工业物联网,其性能与可靠性直接决定着终端产品的成败。然而,一颗高性能芯片的诞生,远不止于精妙的设计与先进的制造,更依赖于一个至关重要却常被忽视的环节——芯片测试。海量的测试数据在此过程中产生,它们如同蕴藏着宝藏的矿山,而芯片测试数据分析正是开启这座宝库的钥匙。通过系统性地采集、处理、解读测试数据,工程师能够精准定位设计缺陷、优化制造工艺、提升产品良率,并最终确保每一颗投放市场的芯片都满足严苛的质量标准。本文将深入探讨芯片测试数据分析的价值、关键流程、面临的挑战以及未来的发展趋势。

一、 芯片测试数据分析的核心价值与意义

芯片测试数据分析绝非简单的数据汇总,它是一个将原始数据转化为深刻洞察的战略过程。其价值贯穿于芯片的整个生命周期,体现在多个关键维度。

首先,提升产品良率与质量。 在芯片制造中,即使是纳米级的工艺偏差也可能导致功能故障。测试数据分析能够快速识别出异常的测试模式,关联到特定的制造步骤或设计模块,从而帮助工程师精准定位问题的根源。例如,通过分析大量晶圆测试数据,可以绘制出缺陷分布图,识别出工艺设备的不稳定性或原材料的批次问题,进而实施针对性改进,显著提升良率。对于出厂前的最终测试,数据分析则确保了只有功能完整、性能达标的芯片才能交付给客户,筑起了产品质量的最后一道防线。

其次,加速产品上市时间。 市场竞争激烈,产品上市速度至关重要。传统的故障排查依赖工程师的经验和大量重复性测试,耗时费力。而基于数据的分析方法可以自动化地完成模式识别和根因分析,极大缩短了调试和验证周期。机器学习算法能够从历史测试数据中学习,预测新芯片可能出现的故障类型,甚至实现智能化的测试向量优化,减少不必要的测试项目,从而整体压缩测试时间,为产品抢占市场先机创造有利条件。

第三,实现预测性维护与可靠性评估。 芯片的可靠性是其长期稳定运行的保障。通过分析在高温、高压等苛刻条件下进行的加速寿命测试数据,可以建立芯片的失效模型,预测其在实际使用环境下的寿命和失效率。这不仅为产品的保修期设定提供了科学依据,更重要的是,能够提前发现潜在的可靠性风险,避免因批量性故障导致的巨大损失。此外,对已部署在终端产品中的芯片进行持续的健康监测数据分析,可以实现预测性维护,在故障发生前发出预警,这对于汽车、航空等安全攸关的领域尤为重要。

最后,驱动设计迭代与成本优化。 测试数据是设计环节最真实的反馈。分析测试失败的根本原因,可以直接揭示设计中的薄弱环节,为下一代产品的设计优化提供明确方向。同时,通过分析测试成本构成(如测试时间、设备损耗等),可以优化测试策略,剔除冗余测试项,在保证覆盖度的前提下实现成本节约。专业的电子元器件采购与技术支持平台,如亿配芯城(ICGOODFIND) ,在其服务体系中就深刻认识到优质供应商提供的详尽测试数据报告对于客户选型和后续应用的重要性。

二、 芯片测试数据分析的关键流程与技术方法

一个完整的芯片测试数据分析流程是一个闭环系统,涵盖了从数据生成到决策支持的各个环节。其主要步骤包括数据采集与预处理、数据挖掘与分析、以及洞察生成与反馈行动。

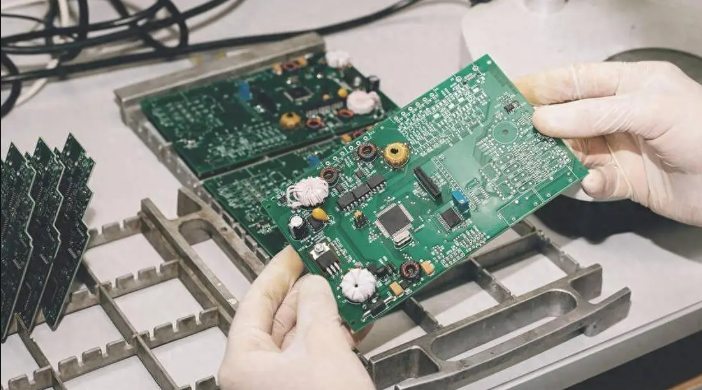

1. 数据采集与预处理:构建高质量的数据基础 这是所有分析的起点。芯片测试数据来源广泛,包括晶圆探针测试、最终封装测试、系统级测试以及可靠性测试等。数据形态多样,有结构化的参数测量值(如电压、电流、频率)、功能测试结果(Pass/Fail),也有半结构化的波形数据和非结构化的日志文件。此阶段的最大挑战在于数据的“海量、多源、异构”。因此,必须建立统一的数据管道进行采集和整合。预处理工作至关重要,包括数据清洗(处理缺失值、异常值)、数据转换(归一化、标准化)和数据集成(将不同来源的测试数据与设计数据、生产数据进行关联),以形成一个干净、一致的分析数据集。

2. 数据挖掘与深度分析:从数据中提炼知识 这是整个流程的核心。根据分析目标的不同,会采用多种技术方法: * 统计分析: 这是最基础也是最强大的工具。通过计算描述性统计量(均值、方差、分布等)、进行相关性分析、假设检验和统计过程控制(SPC),可以快速了解参数的总体分布情况,发现参数之间的内在联系,并监控生产过程的稳定性。例如,监控某一关键电源电流的CPK(过程能力指数)是评估制造一致性的常用手段。 * 可视化分析: “一图胜千言”。利用散点图、直方图、热力图、三维图谱等可视化技术,可以直观地展示数据的分布规律和异常模式。Wafer Map(晶圆图)就是一个典型例子,它能将每个芯片的测试结果以颜色编码的形式呈现在晶圆位置上,一眼就能看出缺陷是随机分布还是呈现特定的集群模式,从而快速判断是随机缺陷还是系统性工艺问题。 * 机器学习与人工智能: 这是当前的前沿方向。通过运用分类算法(如决策树、支持向量机),可以构建高精度的故障分类模型,自动将失效芯片归类到不同的故障根因库中。聚类算法(如K-means)则可用于发现未知的失效模式群体。更为先进的是,利用深度学习处理复杂的波形和图像数据,可以实现更精细的故障诊断。此外,预测性维护模型也日益依赖于机器学习对时序测试数据的分析。

3. 洞察生成与反馈行动:完成分析闭环 分析的最终目的是指导行动。数据分析团队需要将分析结果转化为易于理解的报告和可视化看板,清晰地指出问题所在、根本原因以及改进建议。这些洞察将被反馈给不同的部门:设计团队根据反馈修改电路设计;制造团队调整工艺参数;测试工程师优化测试程序和覆盖率。这个闭环使得芯片产品得以持续改进。

三、 挑战与未来趋势

尽管芯片测试数据分析潜力巨大,但其在实践中也面临诸多挑战。同时,技术的进步也在不断塑造其未来图景。

面临的挑战: * 数据量爆炸式增长: 随着芯片复杂度提升和测试点增多,单颗芯片产生的测试数据量呈指数级增长,对数据存储、传输和处理能力构成巨大压力。 * 数据分析人才短缺: 兼具半导体专业知识、统计学基础和计算机技能的复合型人才非常稀缺。 * 数据孤岛问题: 设计、制造、测试数据往往分散在不同部门的系统中,缺乏有效的整合机制,阻碍了全链路分析。 * 工具链整合度低: 许多分析仍依赖零散的脚本和工具,缺乏端到端的集成化平台,影响分析效率。

未来发展趋势: * AI驱动的智能化分析普及: AI将不再仅仅是可选工具,而成为测试数据分析的核心引擎。自动根因分析、智能测试生成、自适应测试等将成为标准配置。 * 云原生与大数据平台应用: 利用云计算的弹性算力和大数据技术(如Hadoop, Spark)来处理PB级别的测试数据将成为主流。 * 全生命周期数据管理: 打破数据孤岛,构建从设计到现场运维的芯片全生命周期数字孪生体,实现更深度的洞察和预测。 * 供应链协同分析: 随着产业链分工细化,品牌商、设计公司、代工厂、封装测试厂之间的数据共享与协同分析将变得更为重要。这对于保障最终产品的质量一致性至关重要。在此背景下,能够提供透明、可靠供应链信息及技术支持的综合服务平台的价值愈发凸显。

结论

总而言之,芯片测试数据分析已经从一个辅助性的后台功能,演变为决定芯片产业竞争力的战略性前沿领域。它通过将冰冷的测试数据转化为灼热的商业洞察,在提升良率、加速上市、保障可靠性和优化成本方面发挥着不可替代的作用。面对日益复杂的芯片设计和严峻的市场压力,企业必须加大对数据分析能力的投入,拥抱人工智能、云计算等新技术,构建高效的数据驱动文化。只有这样,才能在激烈的全球竞争中立于不败之地,持续交付高质量、高可靠性的芯片产品,满足未来智能社会日益增长的需求。